Observatoire Canadien de l'Hydrogène : observer,…

L'IA générative révolutionne le monde de l’entreprise et contribue à créer de nouveaux modèles commerciaux. Toutefois, ces systèmes font émerger de nouveaux risques qu’il convient de mitiger grâce à un cadre dédié.

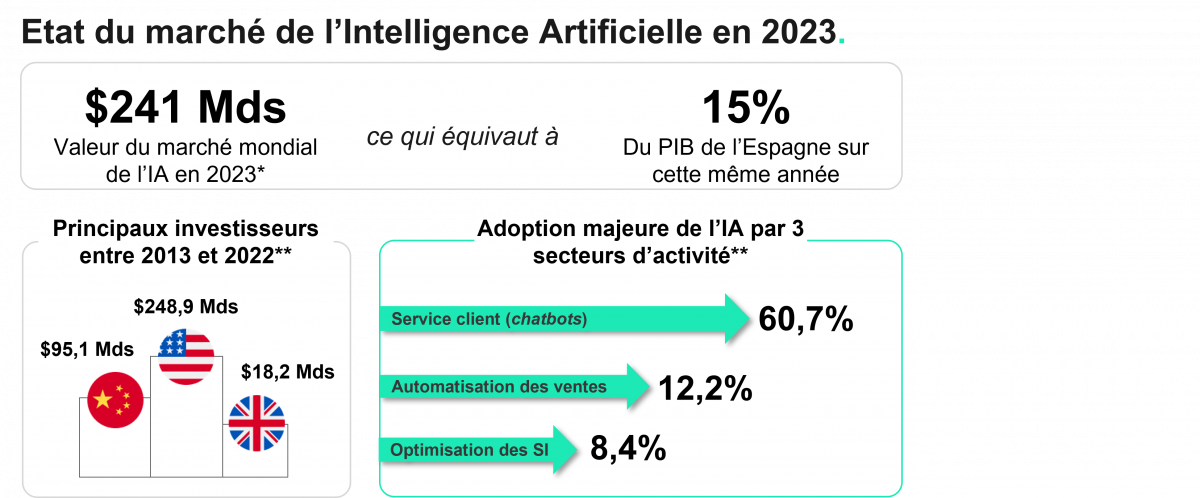

L’année 2024 a été marquée par l’intronisation de l’Intelligence Artificielle, une technologie définie par le Parlement européen comme « la possibilité pour une machine de reproduire des comportements liés aux humains, tels que le raisonnement, la planification et la créativité ». Ainsi, l’agent conversationnel ChatGPT crée par OpenAI a fait l’objet d’un engouement immédiat dès sa mise à disposition du grand public. Les promesses majeures de l’Intelligence Artificielle générative, notamment son potentiel d’amélioration des performances opérationnelles via des capacités d’analyse, de prise de décision et d’interaction avec des données non structurées, font de cette technologie un outil stratégique pour les organisations et les institutions qui l’ont massivement adoptée. Effectivement, le gain de productivité associé à l’utilisation de l’IA serait estimé entre 11 et 37% d’ici à 2035.

*Les chiffres 2023-2024 du marché de l’IA dans le monde, étude Bpi France **AI Index Report 2023, Université de Stanford

Il est nécessaire de rappeler que les modèles d’Intelligence Artificielle ne sont pas infaillibles. En effet, ils peuvent alimenter et répandre certains biais de manière extensive, notamment si les données d’entrainement sont historiquement biaisées ou non représentatives des populations ou cas d’usage. Les développeurs sont également susceptibles de transmettre leurs propres biais aux modèles via les décisions qu’ils prennent, les caractéristiques qu’ils sélectionnent ou encore les objectifs qu’ils définissent pour l’algorithme. D’ailleurs, les algorithmes en eux-mêmes peuvent aussi engendrer des biais en raison de leur fonctionnement (biais d’optimisation par exemple), ou amplifier un biais existant en le reproduisant à très grande échelle. En mars 2024, l’UNESCO faisait notamment part de ses inquiétudes concernant les préjugés sexistes des modèles d’IA générative, et recommandait aux entreprises du secteur de diversifier leurs équipes de développement et données d’entrainement. Cette première défaillance a ouvert la voie à des questionnements plus larges concernant la sécurité des modèles d’Intelligence Artificielle, et notamment la protection des données dans les entreprises, dont 40% déclaraient avoir déjà adopté l’IA fin 2023.

En effet, le déploiement massif de l’Intelligence Artificielle dans les milieux professionnels séduit les utilisateurs, qui ont parfois même tendance à s’en remettre exclusivement aux systèmes basés sur l’IA générative pour exécuter leurs tâches, au détriment des bonnes pratiques de confidentialité et de protection de la donnée. Les dirigeants sont ainsi amenés à se questionner quant à la propriété intellectuelle des productions basées sur l’IA, en plus des considérations éthiques et règlementaires. Il en va également de leur responsabilité d’encadrer les usages et d’identifier les opportunités liées à l’IA qui présentent un véritable gain pour leurs activités. Parmi les risques les plus courants et les plus redoutés : les fuites de données, la réutilisation de propriété intellectuelle et les manquements au RGPD qui entrainent des brèches de conformité règlementaire et sont sévèrement punies. Nous pouvons notamment citer pour exemple CLEARVIEW AI, la solution de reconnaissance faciale américaine, qui a écopé de la plus haute sanction applicable par la CNIL en 2022. La sanction prononcée à correspond à 4% du chiffre d’affaires mondial de la société, soit 20 millions d’euros.

Par ailleurs, plusieurs cas d’utilisation malveillante intentionnelle des modèles d’Intelligence Artificielle ont été relevés, et notamment des campagnes de désinformation massives s’appuyant sur des deepfakes. En juin dernier, la start-up californienne OpenAI révélait avoir déjà déjoué 5 opérations d’influence basées sur ses modèles d’IA dans le but de manipuler l’opinion publique en Russie et en Chine. L’adoption, quasi-unanime, de l’Intelligence Artificielle par un large public a également inspiré certains acteurs malveillants à développer des solutions au service du cybercrime. Ainsi, les agents conversationnels malveillants FraudGPT et WormGPT auraient été identifiés courant 2024 sur des forums prisés par la communauté des hackers. Ces deux solutions largement inspirées de ChatGPT, font abstraction des contraintes légales et morales de ce dernier. Elles proposent notamment d’assister leurs utilisateurs dans la génération de contenu de phishing ou encore dans la rédaction de malwares via des scripts Python. D’une façon plus globale, la puissance calculatoire des modèles d’Intelligence Artificielle permet une plus grande sophistication, une augmentation de la rapidité d’exécution des attaques et un élargissement du périmètre cible. En l’absence de règlementations et de contrôles appropriés, l’IA peut ainsi servir l’automatisation et l’industrialisation des cyberattaques via des scripts malveillants, des self-learning malwares, les attaques par évasion, l’exploitation de vulnérabilités Zero Day, des campagnes de phishing automatisées, etc.

La sécurisation de l’Intelligence Artificielle, qui doit prendre en compte différentes menaces comme l’explique l’OWASP dans son guide LLM AI Cybersecurity and Governance checklist, est un chantier fondamental pour assurer un avenir à cette technologique réformatrice. Cette tâche revêt un double enjeu : d’une part, il s’agit de sécuriser les systèmes en eux-mêmes et par extension, les données qu’ils manipulent. D’autre part, elle vise à limiter les risques pour les personnes. Ainsi, la sécurisation des systèmes s’appuie notamment sur les principes de Security by Design, parfois déclinés en MLSecOps et AISecOps, et qui permettent d’intégrer des tests dès la conception des algorithmes. En France, les autorités telles que l’Agence Nationale de Sécurité des Systèmes d’Information (ANSSI) et la commission Nationale Informatique et Libertés (CNIL) se sont d’ailleurs saisies de ce sujet afin d’accompagner au mieux les initiatives. Voici quelques-unes des bonnes pratiques qu’il convient de respecter pour ce faire :

Définir et faire appliquer des règles d’utilisation claires, telle qu’une Politique ou un Guide d’utilisation acceptable de l’IA ;

Appliquer les principes du RGPD aux systèmes d’IA, conformément aux guidelines de la CNIL ;

Ne pas entrainer un modèle sur des données qui ne doivent pas être accessibles des utilisateurs finaux ;

Mettre en place des campagnes de sensibilisation et de formation aux risques associés à l’Intelligence Artificielle afin d’éduquer à un usage raisonné de l’IA ;

Auditer de façon régulière les algorithmes pour détecter et corriger les biais et les vulnérabilités qu’ils pourraient comporter ;

Si cela est possible, opter pour une IA propriétaire durcie et auditée, c’est-à-dire dont le code source n’est pas accessible au public, a fait l’objet d’un audit de code et pour laquelle l’entreprise chargée du développement conserve les droits de propriété intellectuelle. Le durcissement fait quant à lui référence à un ensemble de mesures de sécurité visant à renforcer la protection contre les attaques et vulnérabilités. Ce type d’IA permet notamment d’assurer une meilleure maîtrise du cycle de vie des données et des actifs supports (serveurs, etc.) tout en offrant un contrôle plus direct des phases développement et de d’apprentissage des modèles ;

Réaliser des activités de veille pour anticiper les exigences de conformité règlementaire liées à l’utilisation de l’Intelligence Artificielle et des solutions qui en découlent (assistants de programmation, etc.).

Pour conclure, l’adoption rapide et massive de l’Intelligence Artificielle impose une vigilance accrue face aux cybermenaces et aux dérives potentielles. En effet, les bénéfices prometteurs de l'IA ne seront pérennes que si des mesures de sécurité rigoureuses et des pratiques éthiques sont mises en place via des efforts conjoints pour établir la confiance à l’échelle mondiale. Forts d’une fine connaissance du secteur et d’une excellente maîtrise des technologies et enjeux associés à l’IA, les experts Sia Partners disposent d’un positionnement unique pour accompagner les entreprises vers un usage transparent et juste de l’Intelligence Artificielle.